- Der Wettlauf um die Erreichung neuer Meilensteine bei der künstlichen Intelligenz erreichte diese Woche einen Höhepunkt. Von Apples neuester Vorstellung bis hin zu großen Fortschritten bei KI-generierten Videos gab es zahlreiche bemerkenswerte Entwicklungen.

- Apple veröffentlichte neue Betaversionen für seine KI-Anwendungen. Verkaufsstart des iPhone 16 und der Apple Watch 10. Beta-Version bietet noch nicht das vollständige Funktionsset der KI. Offizielle Veröffentlichung von 18.1 wird im Oktober erwartet.

- Lionsgate und Runway arbeiten zusammen an einem neuen Videoerzeugungsmodell. Ziel ist die Nutzung von Lionsgates Film- und TV-Inhalten. Partnerschaft soll kosteneffiziente Inhaltsproduktionsmöglichkeiten schaffen.

- Snap bringt neue AR-Brillen auf den Markt. Die Brillen bieten ein erweitertes Sichtfeld und einen beeindruckenden Displayeffekt. Snap arbeitet mit OpenAI zusammen, um cloud-basierte multimodale KI-Modelle zu integrieren.

- YouTube integriert DeepMinds Veo-Videoerzeugungsmodell in YouTube Studio. Die Technologie ermöglicht die Erstellung von Clips in verschiedenen filmischen Stilen allein aus Textvorgaben. Neue Features sollen als Brainstorming-Assistent fungieren.

- Der Betrieb von KI-Modellen verbraucht erhebliche Ressourcen. Ein großer Sprachmodell-Server benötigt Energie zum Kühlen von Wasserflaschen und für LED-Lampen. Sollten wir originelle Ideen entwickeln, anstatt Ressourcen zu verschwenden.

Der Wettlauf um die Erreichung neuer Meilensteine bei der künstlichen Intelligenz erreichte diese Woche einen Höhepunkt. Von Apples neuester Vorstellung bis hin zu großen Fortschritten bei KI-generierten Videos gab es zahlreiche bemerkenswerte Entwicklungen.

Apple Intelligence macht Fortschritte

Der Gerätehersteller aus Cupertino hatte eine ereignisreiche Woche. Mit der Veröffentlichung neuer Betaversionen für seine KI-Anwendungen, gefolgt vom Verkaufsstart des iPhone 16 und der Apple Watch 10, brachte Apple einige bedeutende Updates. Die Beta bietet jedoch noch nicht das vollständige Funktionsset der KI – dies wird erst mit der offiziellen Veröffentlichung von 18.1 im Oktober erwartet. Dennoch können Nutzer bereits einen Eindruck davon gewinnen, was die generative KI bald zu leisten imstande sein wird. Die bestehende Version benötigt allerdings noch einige Verfeinerungen und Anpassungen, bevor sie für die breite Öffentlichkeit tauglich ist.

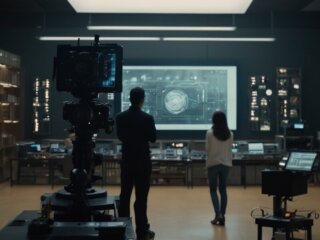

Lionsgate und Runway: Partnerschaft zur KI-Videoerstellung

Lionsgate scheint sich von der allgemeinen Skepsis gegenüber generativer KI nicht abschrecken zu lassen und hat eine Zusammenarbeit mit Runway angekündigt, den Schöpfern des Gen-3-Alpha-Videoerzeugungsmodells. Ziel dieser Partnerschaft ist es, ein neues Videoerzeugungsmodell zu entwickeln und zu trainieren, das Lionsgates umfangreiche Film- und TV-Inhalte nutzt. Diese innovativen Methoden sollen kosteneffiziente Inhaltsproduktionsmöglichkeiten schaffen, was bei Filmliebhabern jedoch die Befürchtung aufkommen lässt, dass dies ein Versuch sein könnte, die Arbeit vieler Filmschaffender durch generative KI zu ersetzen.

Snap lanciert neue AR-Brille

Snap gibt nicht auf und bringt erneut AR-Brillen auf den Markt. Die neuen spektakulären Spectacles bieten ein erweitertes Sichtfeld und einen Displayeffekt, der mit einem 100-Zoll-Bildschirm in zehn Fuß Entfernung vergleichbar ist. SnapOS und die dazugehörige Smartphone-App haben ebenfalls bedeutende Verbesserungen erhalten. Tatsächlich arbeitet Snap mit OpenAI zusammen, um „cloud-basierte multimodale KI-Modelle“ in die Brillen zu integrieren. Die neuen Brillen wiegen stolze 226 Gramm und sind derzeit nur für Entwickler erhältlich, die 99 US-Dollar pro Monat für den Zugang zu dem Programm bezahlen. Ein Veröffentlichungsdatum für eine Konsumentenversion gibt es bisher noch nicht.

YouTubes neue KI-Tools revolutionieren die Content-Erstellung

YouTube verfolgt das Ziel, den Einstieg für neue Content-Ersteller zu erleichtern und den Wettbewerb mit Plattformen wie TikTok anzunehmen. Google gab bekannt, dass DeepMinds Veo-Videoerzeugungsmodell in YouTube Studio integriert wird. Mit dieser Technologie können sechs Sekunden lange Clips in 1080p-Auflösung und in verschiedenen filmischen Stilen allein aus Textvorgaben erstellt werden. Die neuen Features sollen als „Brainstorming“-Assistent fungieren, der Themen vorschlägt, Titel und Thumbnails erstellt sowie die ersten Zeilen eines Skripts generiert. Zusätzlich ermöglicht Dream Screen die Erstellung statischer Hintergrundbilder, die anschließend mit Veo animiert werden können.

Datenverbrauch bei KI beachten

Interessant ist, dass der Betrieb solcher KI-Modelle erhebliche Ressourcen benötigt: Ein großer Sprachmodell-Server verbraucht etwa die Energiemenge, die nötig ist, um drei Flaschen Wasser zu kühlen und 14 LED-Lampen eine Stunde lang zu betreiben. Vielleicht sollten wir unsere kreativen Köpfe nutzen, um originelle Ideen zu entwickeln, anstatt Ressourcen zu verschwenden, nur um auf die rückgekoppelten Vorschläge dieser KIs zu hören.

Runways Gen-3 Alpha bietet Video-zu-Video-Generation

Runway hat diese Woche eine neue Funktion für sein Gen-3-Alpha-Videoerzeugungsmodell vorgestellt: die Möglichkeit, den Filmstil eines jeden Videos allein durch Textvorgaben zu ändern. Diese Neuerung erfreut sich großer Beliebtheit bei KI-Enthusiasten. Zudem hat Runway eine API vorgestellt, die Drittentwicklern die Integration des Video-Modells in ihre eigenen Anwendungen ermöglicht.